|

| Guantes para el reconocimiento de la lengua de signos (foto: KOMO News) |

Reconocimiento de vídeo

Utilizando una o varias cámaras de vídeo convencionales o webcams junto a complejos algoritmos informáticos y matemáticos, se han llevado a cabo numerosos experimentos e investigaciones para el reconocimiento visual de la lengua de signos. En la literatura científica puede encontrarse una gran cantidad de artículos sobre esta técnica para la traducción de lengua de signos a lengua oral.Kinect

Dentro de los sistemas de reconocimiento de vídeo, destaca Kinect, un dispositivo de entrada diseñado por Microsoft para su consola de videojuegos Xbox 360. Sus buenos niveles de reconocimiento visual junto al controlador de código abierto presentado en 2010 hizo que muchas personas de todo el mundo se lanzaran a crear sus traductores de lengua de signos. La propia Microsoft apoyó este tipo de proyectos.Leap Motion Controller

Este es un pequeño dispositivo que pretende sustituir al tradicional ratón para interactuar con el ordenador. Se conecta al puerto USB y detecta los movimientos de la mano que funciona como puntero en la pantalla. Recientemente se ha experimentado su uso para el reconocimiento del alfabeto de la lengua de signos americana (ASL):Los guantes

Uno de los guantes más famosos en los últimos años son los creados por dos estudiantes de la Universidad de Washington en 2016. No eran los primeros guantes pero tuvieron una fuerte repercusión en los medios.El primero de estos guantes con este propósito se anunció ya en 1988 por investigadores de la Universidad de Stanford, llamados "guantes hablantes" (talking glove). Desde entonces no han parado de salir guantes, de ganar premios y prestigio creyendo inventar la rueda: además de los anteriores estudiantes de la Universidad de Washington que ganaron un premio de 10.000 dólares, un estudiante de secundaria de Colorado (Estados Unidos) recibió una beca de 100.000 dólares en 2001 por un guante que sólo era capaz de traducir el alfabeto dactilológico, un grupo de estudiantes ucranianos ganó 25.000 dólares solo por la propuesta en una competición de ideas de Microsoft (Imagine Cup), y así sucesivamente en México, Arabia Saudita, Reino Unido, India, etc.

La pulsera o brazalete

Detrás de esta pulsera o brazalete está una startup española. Se llama Showleap y se colocan en cada brazo, detectando los movimientos musculares de la lengua de signos y lo transmite vía bluetooth al ordenador para su traducción a voz.En el futuro: la realidad aumentada

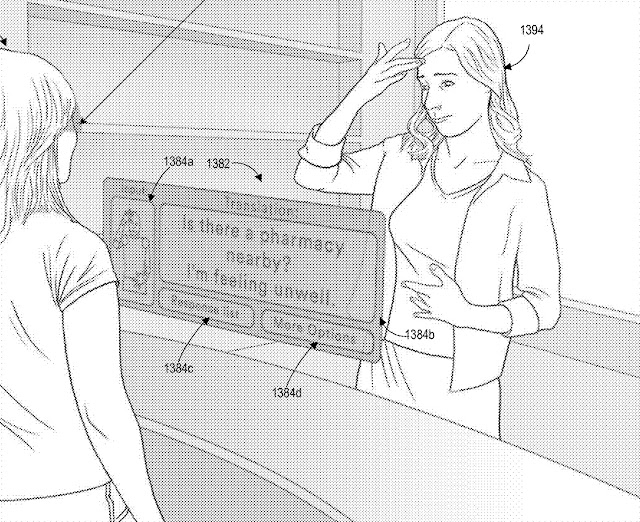

Lo último es una patente de la empresa estadounidense Magic Leap para realidad aumentada. Las gafas de realidad aumentada de Magic Leap comenzaron a comercializarse muy recientemente en 2018 solo en algunas zonas de Estados Unidos al precio de 2.295 dólares. Aunque no son las primeras gafas de realidad aumentada, recientemente patentaron un sistema de traducción de la lengua de signos. |

| Patente de Magic Leap para la traducción automática de la lengua de signos americana (foto: Magic Leap/USPTO) |

¿Por qué son inútiles todos estos sistemas?

Se me ocurren tres motivos principales.Por una parte, es bien sabido que la mejor tecnología es la que no se ve. Pedirle a una persona sorda que al llegar a un determinado lugar tenga que ponerse unos guantes para ser entendida no parece lo más cómodo ni lo más probable. Las pulseras o brazaletes probablemente son más rápidos de colocar, pero no acabo de ver tener que remangarse para ponerlos o llevarlos siempre bajo la ropa. Egoístamente, la patente de Magic Leap me parece, sobre el papel, el mejor wearable porque es la persona oyente quién tendrá que ponerse el dispositivo, no la persona sorda.

Por otra parte, por mucho que avance la tecnología, la traducción automática de las lenguas de signos nunca será viable si no hay un avance lingüístico a la par. Es imprescindible la investigación sobre las reglas gramaticales que rigen las lenguas de signos y sobre la semántica para posibilitar la traducción automática basada en reglas o basada en el corpus, los dos principales tipos de traducción automática en la actualidad.

Y, por último, no menos importante, las tecnologías que hacen una captura de las manos, como los guantes, los brazaletes o el Leap Motion Controller, obvian dos componentes lingüísticos de suma importancia en la lengua de signos: la expresión facial y el movimiento del cuerpo. Básicamente, la expresión facial proporciona información como el tamaño, la magnitud o la intensidad de algo, e incluso modifican el significado del signo. El movimiento del cuerpo proporciona información sobre el rol o la clase de oración, por ejemplo.

Un ejemplo muy típico en lengua de signos española de signos que se diferencian por la expresión facial: dolor (a la izquierda) y dulce (a la derecha). Vídeos: Spread The Sign

Hacia un sistema de traducción automática viable

Ojalá que algún día lleguemos a ver un sistema de traducción automática de lengua de signos a lengua oral que funcione con un mínimo de fiabilidad, ya que esto permitirá positivamente optimizar los recursos económicos en intérpretes de lengua de signos humanos. Los avances tecnológicos son completamente necesarios pero deberán acompañarse de la misma inversión económica y humana en la investigación lingüística sobre las lenguas de signos. Por supuesto, esta investigación lingüística solo puede hacerse contando con personas sordas expertas en la lengua de signos, entre otros profesionales.Las tecnologías de wearables vistas más arriba (guantes, pulseras, etc.), de continuar evolucionando, probablemente encuentren su utilidad en determinados contextos o funciones, pero creo que la tecnología menos invasiva para las personas sordas y con más posibilidades de extenderse, incluso a dispositivos móviles, es el reconocimiento de vídeo.

Salvo que se produzca algún descubrimiento importante o una inversión económica inesperada, faltan muchos años para conseguir un sistema de traducción automática de la lengua de signos funcional como para los idiomas orales. Todas las experiencias conocidas hasta el momento son aún toscas y obtienen buenos resultados sólo en contextos comunicativos muy, muy restringidos. Mientras tanto, por favor, dejen de anunciarlo tanto como "traducción automática de la lengua de signos" y añadan alguna coletilla realista, si no para evitar falsas expectativas en las personas sordas, al menos en respeto a la complejísima labor de las miles de personas en todo el mundo profesionales de la interpretación de las lenguas de signos.

Fuentes:

- Erard, M. (2017, noviembre, 9). "Why Sign-Language Gloves Don't Help Deaf People". En The Atlantic. En línea: https://www.theatlantic.com/technology/archive/2017/11/why-sign-language-gloves-dont-help-deaf-people/545441/ [último acceso: 25/09/2018]

- Kramer, J., y Leifer, L. (1988). The talking glove. ACM SIGCAPH Computers and the Physically Handicapped, (39), 12-16.

- Tao, W., Lai, Z. H., Leu, M. C., y Yin, Z. (2018). American Sign Language Alphabet Recognition Using Leap Motion Controller. En: Proceedings of the 2018 IISE Annual Conference. En línea: http://amz.xcdsystem.com/C5AB9227-CA78-AE70-2946FDB80F96639A_abstract_File8390/FinalPaper_1720_0306092921.pdf [último acceso: 23/09/2018]

- University of Washington News (2016, abril, 12): "UW undergraduate team wins $10,000 Lemelson-MIT Student Prize for gloves that translate sign language". En línea: https://www.washington.edu/news/2016/04/12/uw-undergraduate-team-wins-10000-lemelson-mit-student-prize-for-gloves-that-translate-sign-language/ [último acceso: 23/09/2018]

- Wanshel, E. (2016, abril, 28). "Students Invented Gloves That Can Translate Sign Language Into Speech And Text". En Huffington Post. En línea: https://www.huffingtonpost.com/entry/navid-azodi-and-thomas-pryor-signaloud-gloves-translate-american-sign-language-into-speech-text_us_571fb38ae4b0f309baeee06d [último acceso: 23/09/2018]

0 Comentarios